校园春色你我色 用增结算数仓化变调:在/离线转换系统的构建与应用

导读校园春色你我色

迁徙运营扩充平台(OPS)承载着百度里面迁徙应用/迁徙搜索业务的用户增长预算的全经过结算线上化管控功能,为了贬责用增业务发展限制扩大、原有技巧架构老旧、无离线数仓系统等一系列的问题,针对全域结算数据启动了举座的架构变调。为了贬责业务中存在的问题,本文长远探讨并建议了一类在线、离线勾通的任务转换贬责决策,完成了结算业务架构更新换代,更好地劳动于业务发展。

01 布景简述

1.1 业务/技巧布景

迁徙运营扩充平台(OPS)承载着百度里面的迁徙应用/迁徙搜索业务的用户增长预算的全经过结算线上化管控功能(包括息争方-渠谈信息注册经管、内/外部结算数据接入/展示、预栈单/账单谋划-审批-结算阐明支付等一系列主要经过),已为迁徙搜索分红、用增扩充等业务线提供了十余年的劳动。

跟着用增业务发展与线上化管控限制的扩大,业务结算量级、结算数据量与审批单量培育,原稀有据层技巧架构老旧,逐步承载不住日益增长的结算时效性、准确性要求,导致结算出账数据额外/产出失败,形成本色业务蚀本。

平台历史上的结算观念、账单数据均通过PHP/Java剧本谋划,通过MySQL数据库对储存中间数据与效果数据,无离线数仓,存在易删改、无留痕等数据审计风险。因此针对用增结算全域结算数据立项,启动了离线任务的数仓化变调。为了贬责在线业务与离线结共谋划间自然不兼容的问题,空洞接头用增结算运营的天真性和结算数据谋划的准确性,咱们建议了一类在线与离线勾通的任务转换贬责决策,当今已承载了线上亿级别月度结算账单的谋划、出账、定期产出和更新。

1.2 名词阐扬

TDS:Turing Data Studio 是基于图灵(百度里面数据分析平台)的数据建设贬责决策,提供 数据斥地、数仓经管、监控运维、资源经管等一站式劳动的数据斥地平台。

BigPipe(现DataHub):百度里面防范的散播式音信系统,可通过Topic或Queue状貌使用。

02 技巧决策瞎想

2.1 业务特色分析

用增结算相较于其他业务离线数仓的特色是:业务受外部影响较大,操作和计谋的制定较为天真;业务侧的变更需要实时同步到数据层谋划/重算,同期需要保证谋划经过的准确合规。时常存在依赖数据的小范围更新case(如个别渠谈舞弊判定、某个息争方条约信息的修改、出账决策养息等),因此斥地的任务都领有较强的天真性,相关离线剧本也都相沿对单条/指定范围的数据进行谋划/更新重算。

本来的离线剧本模块经过万古期的迭代发展,存在以下问题:

数据谋划/更新时无法感知非预期的变更。条约更新、反舞弊处理等经过当作进修的业务经过领有较完善的实时/定时处理机制(针对上游业务数据变更更新对应的下流报表、账单数据),但濒临非架构原生、后续迭代新增的功能,只可通过运营/产物侧通过范围象征(指定息争方/结算类型等)手动发起相应的重算,在此过程中可能存在信息丢失/误操作等情况,导致全局崎岖游不一致;

数据范畴区别蒙胧,存在兼并字段由多个线上模块/剧本认真更新的情况,在逻辑突破时存在潜在的幂等性问题;

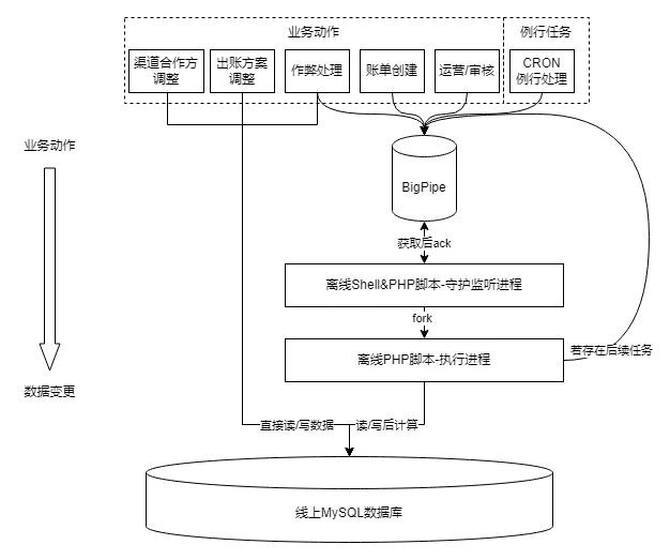

剧本劳动话语架构旧(PHP+Shell剧本),无可视化界面和运维技能,存在相比严重的单机热门问题/BigPipe API厚实性问题,影响账单谋划的准确性/时效性。

女教师日记为了克服旧架构的污点,同期保留其天真反馈运营动作的优点,需要对数仓化变调决策以及平台间的衔尾放肆进行充分瞎想。

2.2 平台数仓化架构瞎想和变调念念路

架构变调应基于业务特色与符合的瞎想进行,那么该怎样立异现架构,保证功能不蚀本还有新收益?

由于PHP在我厂早期大宗用于快速斥地平台与剧本,因此逻辑在平台与剧本上耦合度很高。平台业务,定时转换,以至剧本自己都不错调起剧本进程,且平台和离线剧本均径直对线上库进行读写操作。这种架构天真性很高、有益于功能快速迭代,但两侧逻辑一朝产生互异,就会丢失数据的一致性;相关的中间件也莫得调处的状况查询经管界面,音信的堵塞和丢失都会导致问题溯源十分贫穷。

同期,咱们不雅察到当今的数据逻辑中,很大一部分代码被用于判断状况流转(现时票据/条约是否应被重算),但这部分逻辑关于金额谋划是完满无关的,况且对应的查询花销在扫数谋划过程中的耗时也达到30%以上,存在优化的空间。

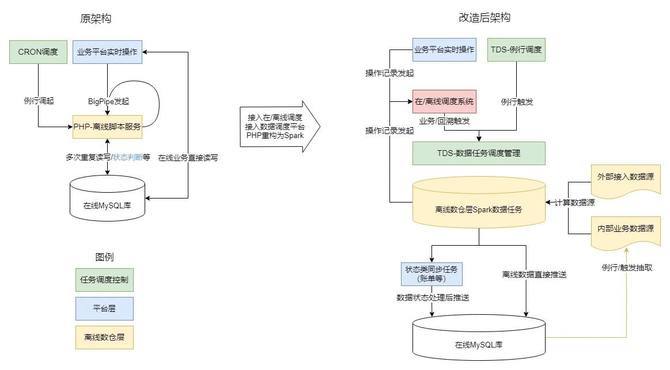

为了贬责现时逻辑耦合、冗余的问题,咱们决定在启动变调时将平台与数仓的逻辑分离:平台专注于业务数据录入和状况流转,数仓专注于结算数据谋划如具体的观念和结算金额。把账单谋划逻辑千里淀到离线侧,幸免谋划/修改逻辑分离产生的数据不一致风险,运用数仓层的数据版块放肆和血统讲究等能力,确保结算数据的准确性、一致性和可讲究性,同期将数据任务调处接入TDS等进修的数据任务经管平台,简化了分散在多个平台上的数据经管和运维职责。

具体的逻辑拆分念念路如下:

率先将依赖离线任务产出的数据报表进行字段级范畴区别,阐明两方职责:数仓层认真产出结算支付相关字段,平台层认真对外展现,同期认真在审批、业务经过中更新状况类字段。

合手住转换进口,例行类和事件触发类转换的底层由分别发送异构BigPipe音信启动改为调处纪录业务操作纪录,由特意的转换体系调处发起转换。

对现时触发离线谋划的事件进行逻辑归因:

业务操作(平台自己的数据变更、数据任务触发的业务变更)驱动的数据变更,谋划/重算任务应当由平台主动发起,均通过特意的转换体系调处转换。

外部数据源驱动的数据变更,谋划/重算任务应当由数仓主动发起,通过TDS的转换回溯功能进行调处经管。

2.3 在/离线转换系统

在上述念念路的基础上,咱们瞎想与竣事了一个特意的转换系统来统筹经管离线谋划任务:该系统同期兼顾业务崎岖游依赖关系和数据崎岖游血统关系,对谋划任务进行有序的转换经管。

关于结算类数据,在数据时效性(操作敕令实时产出对应的结算数据)和一致性之间,一致性更过错(每次谋划均需要保证结算数据的全量准确性),时效性相对而言是可就义的(产出晚好过产出乖谬的结算账单)。在此假定下,需要瞎想构建一个能保证结算数据准确性,同期时效性相对不差(发起变更1小时内可完成谋划)的结算类任务转换系统。

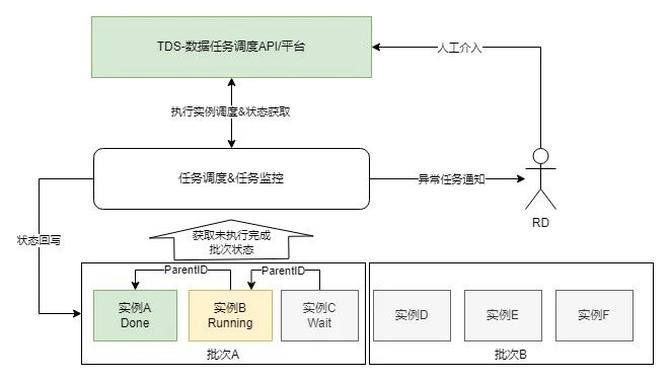

举座瞎想

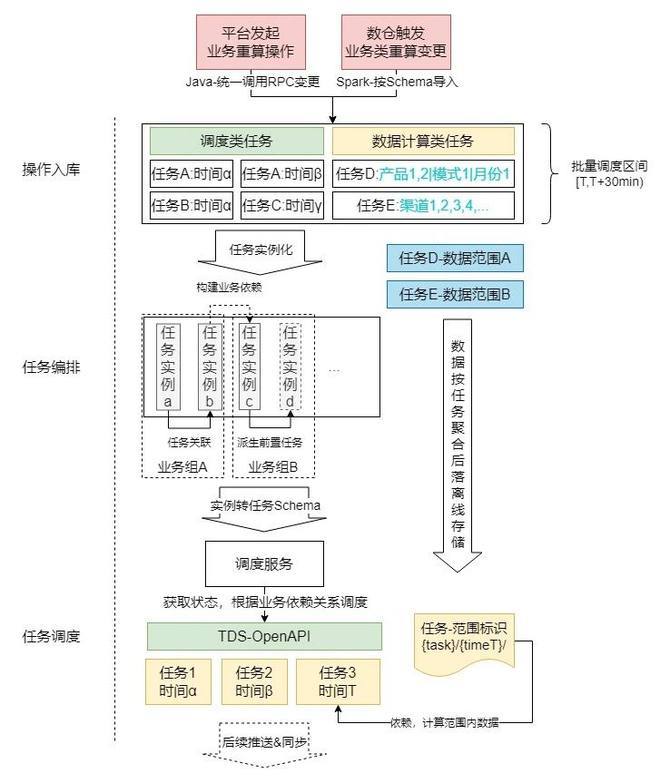

转换系统的举座架构和经过见下图:

通过以上3个步骤,完成业务层与离线谋划层间的交互:

1.操作入库:向操作MySQL表中写入待实行任务如反舞弊报表重算、账单重算等;因操作基本按月/日维度实行,绝大部分操作类型的操作数不进步100次/月,故暂不引入缓存等中间件,减少系统复杂度。

2.任务编排:通过批处理的状貌,将入库操作中写入的操作进行分析后进行团员/关联/派生等操作,生成一批待实行任求实例(保存为数据库纪录);关于数据结算类任务,还会处理成与任务和批次对应的离线文献,供谋划任务调用获得本色需要谋划的数据范围。

3.任务转换:将上一步中编排好实行关系的任求实例转为TDS任务Schema后,调用TDS-OpenAPI,在TDS上触发对应的转换,并将对应的任务状况回写到平台侧。不错通过平台进行任务状况的监控和放肆。

TDS任求实行完惯例行任务/重算任务后,将待更新数据通过算子推送到平台在线库;具体推送的数据取决于不同离线任务的导入建设和业务需求,但每个任务都会将更新写回到数仓,保证数仓中的数据是最新、最准确的版块。

例1:调用例行的数据拉取重算,将逐日结算数据再行拉起谋划,并同步到在线库中供平台查询;

例2:调用反舞弊重算任务,调起对应的任务后,更新数仓效果,并将新老效果中diff部分(更新的数据)同步到在线库中。

操作入库

针对变调前任务启动状貌各自成体系、编程话语夹杂、难以进行统计和迭代变调的情况,本次变调过程中将任务启动调处优化为两种固定状貌:

Java平台侧:通过调处的RPC调用纪录操作至数据表。对平台而言,有且仅有该进口用于操作的入库,浅易后续的任务审计、切面经管、功能调处迭代升级;

Spark数仓离线侧:通过固定的数据Schema导入至操作表。该类径直写入的操作源于历史任务中存在的离线任务中通过BigPipe音信触发调用下流任务,为简化逻辑重构老本保留已有性情。后续将不再新增此类入库状貌,并策画随迭代逐步下线、合手住至平台侧。

任务编排

编排组件周期脱手,针对一批待实行的业务操作进行团员/任求实例化/任务依赖经管,并生成一个全局随期间递加的批次号。主要操作如下:

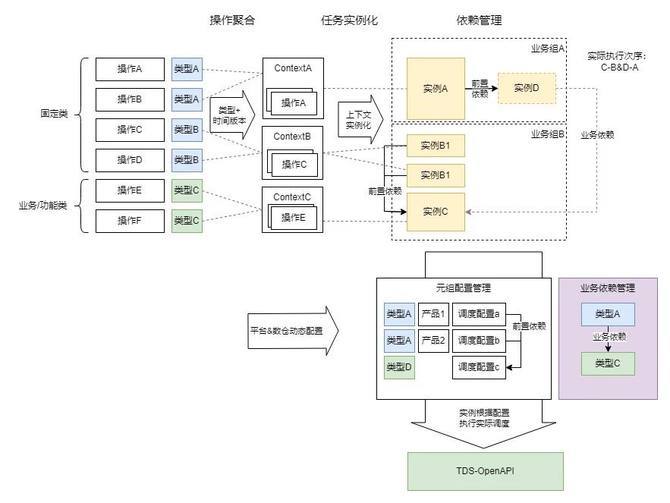

操作团员

基于发起的业务变更操作进行分析,凭据需要操作的数据期间和对应的任务汇聚(如需要修改x月y日的某业务某类型数据)进行团员分组;这么作念的原因是TDS平台的任务组转换均为基于期间序列的转换,将操作按照任务元(从任务类型映射)-任求实行期间(凭据周期类型(月/日/实时)与数据期间转换)分组后,合并/分拨到兼并个或一组相同的数据任求实例,不错最小化转换资源与实行资源的使用。

任求实例化

操作团员到任务类型-任务期间后,凭据对应的任务崎岖文(TaskContext)和相应的建设构造需要启动的1~n个任求实例。任务崎岖文有如下界说:

数据范围:用于笃定需要谋划的范围要求(如指定某条/批账单、某个日历、某个业务类型等)。

任务类型:包含固定类型、业务/功能类型

固定类型主要用于固定的任务,大部分不需要参考数据范围,如某个表数据的全量同步;同类型下每个任务崎岖文代表一个孤苦的任务或功能步骤。

业务/功能类型主要用于需要放肆数据范围实行的任务,如某产物线-某数据版块-某个周期的激活数据拉取;同类型下每个任务崎岖文代表调换功能下不同的数据范围,可精准放肆谋划维度。

任务元组:用于对接任务转换平台(接口界说,关于TDS包括数据任务组、肇端算子、全经过算子),如任务启动和获得任求实例状况,可通过建设MySQL表竣事动态热加载。

依赖经管

本色操作中一批数据任务的实行可能是存在先后逻辑关联,不成同期启动的,因此需要组织合理的转换步骤保证准确性。为了保证该步骤是最优、最简化和容易融会的,咱们引入了以下设定:

前置依赖(隐式依赖)关系:发起业务变更时平台侧不关爱对应的底层数据逻辑,但遮拦数据逻辑是需要在本色转换中发扬的(比如:数据重算发起时,可能需要提前发起一个线上数据同步任务/上游数据拉取任务。任务上游可能因为逻辑、架构迭代而变更,但平台侧并不关爱其养息)。任务策画中可能存在业务侧不关爱但必须实行的前置任务,此时需要凭据依赖关系,自动构建和生成对应的任求实例;若对应的任求实例已存在,则径直进行前置关联。通过该步骤,不错构建出一组相互间无依赖关系的任务依赖树(为幸免引入过多依赖经管的逻辑,不允很多依赖,但允许有多下流),将单独的一棵树称为业务组(该业务组实行完成时标明业务对应的数据任求实行完成,前后数据一致且竟然)

业务依赖(显式依赖)关系:针对某些业务组间存在前后序关联的情况(如A业务依赖B业务数据,赶巧在兼并批次内A、B业务都有操作发起),需要保证实行步骤,幸免产生后序业务先行谋划导致的谋划效果乖谬、额外等情况。

怎样建立业务组间串行实行的关系?关于系统而言转换的单元是实例,不存在业务组这么一个动态的实体,因此咱们通过崎岖文映射实例对应的任务类型,通过类型间业务依赖关系建设(从业务动作的角度进行关联),建立任求实例间的树状依赖,进而放肆业务组间的实行步骤,构成举座的脱手拓扑。

为了分离数仓血统治理问题,保证在/离线转换的业务导向,在编排中不相沿多上游依赖,本色存在的多上游依赖通过崎岖文中的任务元组进行建设,将多个任务抽象都集到单个转换实例中。在这个瞎想基础上,引入了动态依赖(凭据期间版块-数据范围匹配,建立业务功能类任务间的依赖)、依赖链与依赖禁受(A-B-C依赖链上业求实例不全时(如仅存在A、C)凭据优先级建立本色业务依赖(A-C))等设定,更好地劳动于业务逻辑与数据逻辑的衔尾。

通过以上三个步骤,咱们将业务侧发起的业务苦求转换、构建为同批次下的一系列需要实行的数据任求实例以及浅易纪律处理的实行步骤,并委用由转换平台实行。

任务转换

为了保证数据任务的往往实行和处理以及实时反馈进程到平台侧,转换组件包含以下功能:

任求实行&状况同步:凭据任求实例纪录,转换为TDS平台的任务脱手实例,并凭据现时状况、依赖任务状况等信息判断是否启动转换平台任求实例或获得对应的任务状况;任务的转换以批次号为单元,现时批次未实行完之前不可实行下一批次,确保全局不出现数据任务的乱序实行。

任务经管:不错通过任务批次、任务状况以及任务经管界面,或运用TDS平台来经管和感知任务的实行情况。

任务监控:对现时批次内未实行&实行中的任务定时巡检,并通过IM/邮件/短信等状貌报警,实时感知任务额外,并由RD东谈主工介入设立。

03 回归

用增结算类业务当作里面应用扩充对外结算的独一业务平台,对结算数据的准确性、一致性的要求止境高。

针对平台离线谋划历史架构中存在的系统性问题,凭据现时业务特色进行分析、瞎想,进行了举座离线层数据架构的重构校园春色你我色,保证结算数据的逻辑解耦、版块经管、准确性时效性培育、进程与额外实时感知、简化接入与裁汰运营老本。针对在线业务平台与离线数仓架构的衔尾决策,瞎想了一套适用于结算业务的在线/离线转换系统,在保证结算数据谋划准确有序的前提下,保留了平台对业务管控的天真性,同期通过离线任务调惩罚理减少了数据层运维和排查老本,灵验相沿用增线上化结算业务的快速发展。